Trong khi hàng nghìn chuyên gia đang bỏ ra hàng giờ để nghiên cứu cách viết prompt hoàn hảo cho các mô hình AI, một người dùng tên funbite đã chia sẻ một phương pháp đơn giản đến bất ngờ: thay vì tự viết prompt, hãy để chính AI tạo ra và đánh giá prompt cho bạn. Phương pháp này không chỉ tiết kiệm thời gian mà còn cho ra kết quả tốt hơn bất cứ thứ gì con người có thể viết.

Câu chuyện bắt đầu từ việc funbite nhận ra một điều mà nhiều người dùng AI đã bỏ qua: thay vì cố gắng hiểu cách hoạt động phức tạp của các mô hình ngôn ngữ lớn, tại sao không tận dụng chính khả năng "tự nhận thức" của chúng? Ý tưởng nghe có vẻ đơn giản nhưng hiệu quả đến mức đáng kinh ngạc - sử dụng trọng số riêng của AI để tối ưu hóa cách giao tiếp với chính nó.

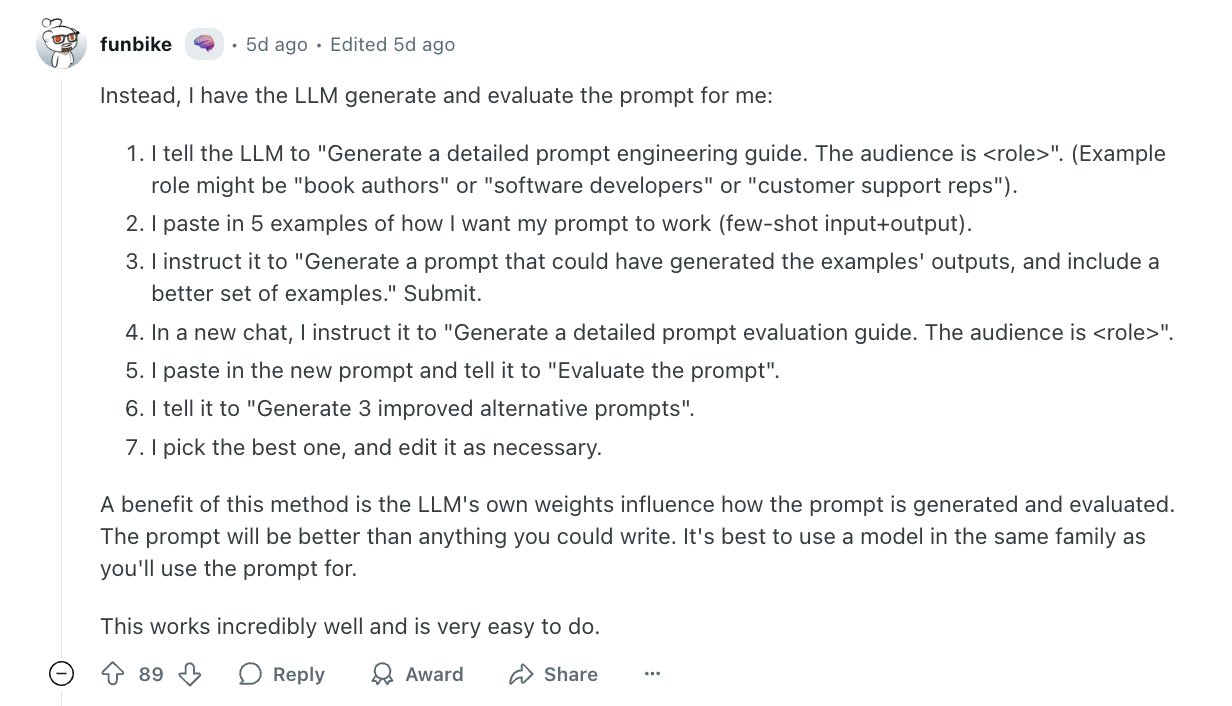

Quy trình được funbite đề xuất bắt đầu bằng việc yêu cầu AI tạo ra một hướng dẫn prompt engineering chi tiết. Thay vì nói chung chung, người dùng cần chỉ rõ đối tượng cụ thể như "Generate a detailed prompt engineering guide. The audience is " (Tạo hướng dẫn kỹ thuật prompt chi tiết. Đối tượng là ) role có thể là tác giả quyển sách hoặc nhà phát triển phần mềm hay nhân viên hỗ trợ khách hàng,.... Điều này giúp AI hiểu được ngữ cảnh và tạo ra hướng dẫn phù hợp với từng lĩnh vực chuyên môn.

Bước tiếp theo mang tính quyết định - cung cấp 5 ví dụ cụ thể về cách bạn muốn prompt hoạt động theo định dạng few-shot learning. Đây chính là chìa khóa giúp AI hiểu được mong muốn thực sự của bạn, không phải qua lời giải thích mà qua các ví dụ thực tế. Sau đó, một câu lệnh đơn giản "Generate a prompt that could have generated the examples' outputs, and include a better set of examples" (Tạo prompt có thể tạo ra kết quả tương tự như các ví dụ và bao gồm một tập hợp các ví dụ tốt hơn) sẽ khiến AI tạo ra prompt tối ưu kèm theo những ví dụ chất lượng hơn.

Điều thú vị nhất nằm ở phần đánh giá. Trong một cuộc trò chuyện hoàn toàn mới, người dùng funbite hướng dẫn người dùng yêu cầu AI tạo ra "Generate a detailed prompt evaluation guide" cho cùng một đối tượng. Việc tách biệt quá trình tạo và đánh giá giúp tránh bias và đảm bảo tính khách quan. Khi dán prompt vừa tạo vào và yêu cầu "Evaluate the prompt", AI sẽ đưa ra những phản hồi chi tiết về điểm mạnh, điểm yếu và đề xuất cải thiện.

Giai đoạn cuối cùng là việc yêu cầu "Generate 3 improved alternative prompts" dựa trên kết quả đánh giá. Từ ba lựa chọn này, người dùng có thể chọn ra phiên bản tối ưu nhất và chỉnh sửa nếu cần thiết. Toàn bộ quy trình này có thể hoàn thành trong vòng 15-20 phút nhưng cho ra kết quả mà các chuyên gia prompt engineering có thể phải mất hàng ngày để đạt được.

Kỹ thuật prompt nói trên sẽ đặc biệt quan trọng trong các lĩnh vực cần có độ chính xác hoặc thông tin chuyên sâu.

Báo cáo của SuperAnnotate năm 2024 đã chỉ ra rằng prompt engineering đã trở thành yếu tố then chốt khi các mô hình AI ngày càng được ứng dụng rộng rãi trong những lĩnh vực đòi hỏi độ chính xác cao như luật pháp và y tế. Sự cần thiết của việc tối ưu hóa prompt không còn là chuyện của các nhà nghiên cứu mà đã trở thành nhu cầu thực tế của hàng triệu người dùng.

Nghiên cứu từ MIT Sloan đã dự đoán từ năm 2023 về khả năng các mô hình AI sẽ tự viết prompt cho chính mình, và phương pháp của funbite chính là minh chứng sớm nhất cho xu hướng này. Kỹ thuật này cũng có điểm tương đồng với G-Eval - một phương pháp sử dụng chain-of-thought để đánh giá output của LLM, như được mô tả trong hướng dẫn của Confident AI.

Phản ứng từ cộng đồng cho thấy sự phân hóa thú vị. Trong khi một số người cho rằng phương pháp này quá phức tạp so với việc viết prompt truyền thống, những người dùng như @kiranadimatyam lại báo cáo thành công khi áp dụng các kỹ thuật tương tự với các mô hình của Anthropic. Điều này phản ánh một thực tế quan trọng: hiệu quả của phương pháp có thể phụ thuộc vào loại mô hình và cách tiếp cận cụ thể.

Xu hướng năm 2025 đang chứng kiến sự bùng nổ của các công cụ tự động hóa tối ưu hóa prompt. Người dùng @philly_doug đã nhắc đến các tool như @promptcowboy, phản ánh nhu cầu ngày càng cao về quy trình làm việc với AI hiệu quả. Điều này không có gì ngạc nhiên khi mà việc tương tác với AI đã trở thành kỹ năng cần thiết trong hầu hết các công việc hiện đại.

Lợi thế lớn nhất của phương pháp này nằm ở việc tận dụng "kiến thức nội tại" của mô hình về cách thức hoạt động của chính nó. Thay vì con người phải đoán xem AI "thích" kiểu giao tiếp nào, phương pháp này cho phép AI tự thiết kế cách giao tiếp tối ưu nhất. Kết quả là những prompt không chỉ hiệu quả mà còn phù hợp hoàn hảo với kiến trúc và training data của mô hình cụ thể.

Tuy nhiên, funbite cũng khuyến nghị một điều quan trọng: nên sử dụng cùng model family với mô hình sẽ áp dụng prompt để đảm bảo tương thích tối ưu. Điều này có nghĩa là nếu bạn định sử dụng GPT-4 cho công việc thực tế, hãy dùng GPT-4 để tạo prompt, thay vì chuyển đổi giữa các hệ thống khác nhau.

Trong bối cảnh mà AI đang ngày càng thống trị các quy trình làm việc, khả năng tạo ra prompt hiệu quả đã trở thành kỹ năng sống còn. Phương pháp của funbite không chỉ là một mẹo hay mà còn là tiền đề cho một cuộc cách mạng trong cách chúng ta giao tiếp với máy móc - một cuộc cách mạng mà ở đó, chính máy móc sẽ dạy chúng ta cách nói chuyện với chúng một cách hiệu quả nhất.